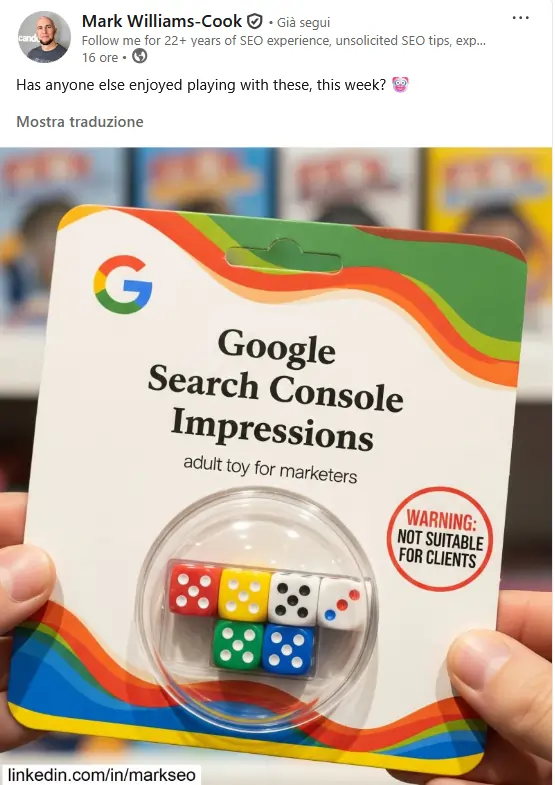

La modifica tecnica ha avuto un impatto diretto su impression e posizioni, sollevando dubbi sui dati e sulle reali intenzioni di Google

📌 TAKE AWAYS

La rimozione del parametro &num=100 da parte di Google ha ridotto le impression registrate e migliorato le posizioni medie. I dati “fantasma” generati dai bot di scraping sono spariti.

Le metriche ora probabilmente riflettono in modo più realistico il comportamento degli utenti.

Se questi giorni hai aperto la tua Google Search Console, potresti aver avuto un sussulto.

Forse due.

O il grafico delle “impression” (le volte in cui il tuo sito appare nei risultati di ricerca) è crollato come un soufflé uscito male dal forno, oppure, ancora più strano, la tua “posizione media” è schizzata verso l’alto con un’agilità che neanche Jury Chechi dei tempi migliori.

Ok, frena l’entusiasmo o la disperazione.

Non hai né vinto alla lotteria, né sei stato bandito dall’esclusivo club della Search.

Quello che stai vedendo è, con ogni probabilità, un miraggio nei dati.

La colpa, o il merito, è di un piccolo, apparentemente innocuo, pezzo di codice che Google ha deciso di far sparire, scatenando un piccolo terremoto nel mondo di chi, come me, lavora per rendere visibile il tuo brand.

Sono qui per guidarti in questo scenario confuso, dove i dati sembrano impazziti e il futuro della ricerca è un dedalo tra intelligenza artificiale, motori di risposta e le vecchie, care pagine blu di Google.

Perché oggi, più che mai, non basta essere visibili.

Bisogna essere visibili nel modo giusto, alle persone giuste, su piattaforme che cambiano alla velocità della luce, come ha ribadito anche Ina Toncheva su SEO Confidential.

Soprattutto, bisogna saper distinguere un successo reale da un’anomalia statistica prima di stappare lo champagne.

Google Search Console è impazzita: cosa sta succedendo ai tuoi dati?

Immagina di guardare il tuo estratto conto e vedere che il tuo saldo è raddoppiato da un giorno all’altro.

La prima reazione è l’euforia.

La seconda è il sospetto.

Ecco, la situazione attuale con la Google Search Console è molto simile.

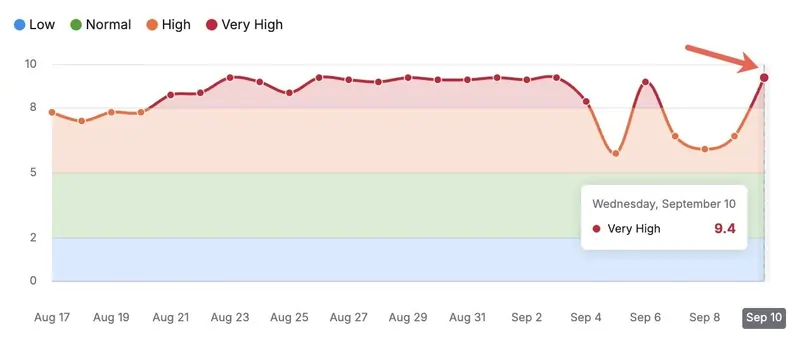

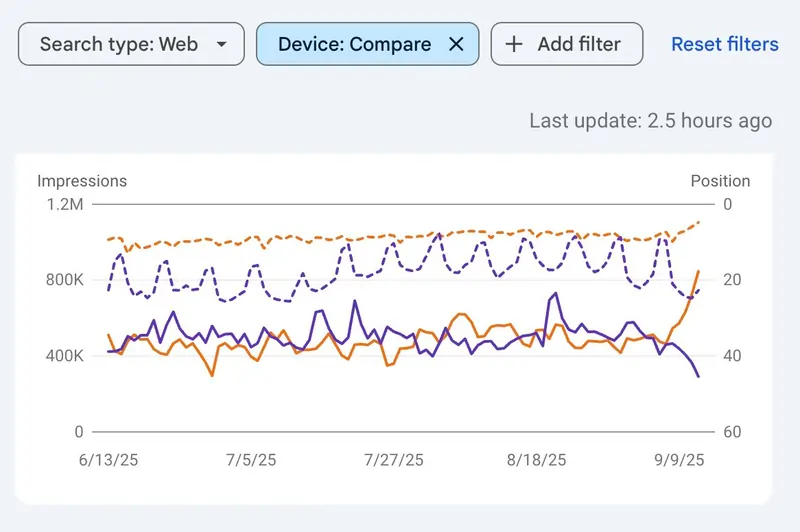

Da metà settembre 2025, imprenditori e professionisti del marketing di tutto il mondo hanno iniziato a notare fenomeni bizzarri nei loro report. In particolare, due tendenze opposte ma collegate: un crollo verticale delle impression registrate da computer desktop e, contemporaneamente, un miglioramento quasi magico della posizione media generale del sito.

Ma come è possibile?

Se meno persone vedono il tuo sito, come può la sua posizione media migliorare così tanto?

Sembra un controsenso, una violazione delle leggi fondamentali della fisica digitale.

Invece, la spiegazione è tanto tecnica quanto affascinante, e ci porta dritti alla questione centrale, ovvero il modo in cui i dati sulla ricerca vengono raccolti. Non solo da Google, ma da tutto l’ecosistema di strumenti che gravita attorno ad esso.

La causa di tutto questo scompiglio, sai qual è stata?

Semplice: la dipartita di un piccolo parametro nelle URL di ricerca di Google: &num=100.

Per anni, questo comando permetteva agli utenti avanzati e, soprattutto, agli strumenti di analisi SEO, di visualizzare 100 risultati di ricerca in una sola pagina, invece dei soliti 10.

Una scorciatoia comoda, efficiente. Un po’ come poter leggere dieci pagine di un libro in un colpo solo. Google, senza annunci ufficiali o squilli di tromba, ha deciso di chiudere il rubinetto. E così facendo, ha rotto il giocattolo a molti.

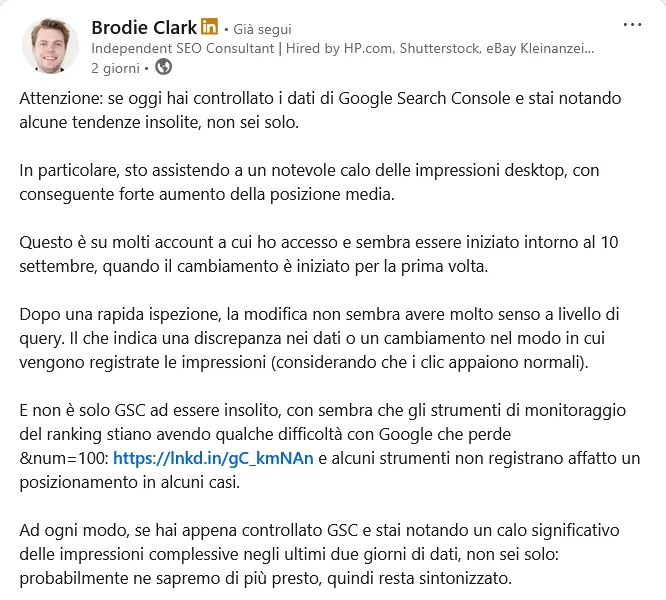

L’intuizione di Brodie Clark: la teoria dei bot e il “Grande Disaccoppiamento” rivisitato

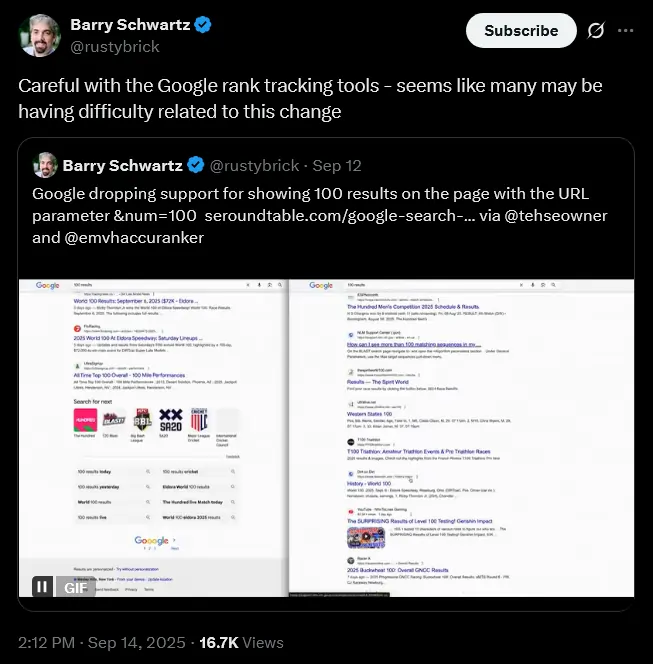

Uno dei primi a lanciare l’allarme e a formulare una teoria coerente è stato Brodie Clark, un esperto SEO indipendente molto rispettato nel settore. Con un post su LinkedIn e un successivo approfondimento sul suo blog, Clark ha messo insieme i pezzi del puzzle.

La sua osservazione è stata acuta: il calo delle impression proveniva quasi esclusivamente dal traffico desktop, che è guarda caso il principale veicolo usato dagli strumenti di scraping.

Cosa sono gli strumenti di scraping?

Immaginali come dei robot instancabili che scandagliano Google giorno e notte per conto dei tool SEO (come Semrush, Ahrefs e altre) per registrare la posizione del tuo sito e quella dei tuoi competitor per migliaia di parole chiave.

Per farlo in modo efficiente ed economico, questi strumenti usavano massicciamente il comando &num=100. In una sola richiesta, ottenevano 100 risultati, accelerando il processo e riducendo i costi.

Qui arriva il punto che ci interessa.

Secondo le regole di Google Search Console, un'”impression” viene registrata non appena il link al tuo sito viene caricato nella pagina dei risultati visibile all’utente.

Non è necessario che l’utente scorra fino a vederlo fisicamente. Ora, pensa a uno di questi bot che chiede a Google 100 risultati.

Se il tuo sito si trova in posizione 99, il bot “vede” il tuo link e Google Search Console registra un’impression.

Ma era un’impression “reale”?

No.

Nessun essere umano l’ha mai vista. Era un’impression fantasma, generata da un processo automatico.

Brodie Clark ha fatto un’ipotesi tanto audace quanto illuminante:

“E se una fetta enorme delle nostre impression desktop non fossero mai state reali, ma solo il frutto di questo scraping massivo?”

Nel suo articolo mostra un grafico impressionante dove un sito perde 200.000 impression desktop da un giorno all’altro. Ti sembra possibile che 200.000 bot visitassero i risultati di Google ogni giorno solo per quel sito? Suona folle, ma forse non lo è.

Questa scoperta getta una luce completamente nuova su un dibattito che ha infiammato la comunità SEO nell’ultimo anno: il cosiddetto “Great Decoupling“.

(Se ricordi, noi ad agosto 2025 abbiamo intervistato Darwin Santos, l’esperto SEO che ha coniato quest’espressione così efficace).

Bene, da quando Google ha introdotto le “AI Overviews” (le risposte generate dall’intelligenza artificiale in cima ai risultati), molti avevano notato un aumento delle impression non accompagnato da un aumento dei click.

La colpa era stata data all’IA, che fornendo la risposta direttamente, disincentivava il click.

Una teoria logica, che Google però ha comprensibilmente sempre respinto.

Ora, grazie all’analisi di Clark, emerge un’ipotesi alternativa: e se quell’aumento spropositato di impression non fosse dovuto all’IA, ma a un’intensificazione dello scraping da parte di nuovi e vecchi strumenti, magari spinti dalla necessità di analizzare proprio le nuove risposte IA?

Disabilitando il parametro &num=100, Google potrebbe aver involontariamente sgonfiato una bolla di dati “sporchi”, mostrandoci una realtà molto diversa da quella che pensavamo.

La tua posizione media è migliorata perché, eliminando tutte quelle impression fantasma nelle posizioni 80, 90 o 100, la media si calcola solo sulle posizioni più alte e reali, quelle viste da veri esseri umani.

Non sei diventato più abile quindi, è solo che il termometro si è ricalibrato.

Perché Google ha fatto questa mossa? Le ragioni dietro il sipario

Al momento in cui scrivo, da Mountain View tutto tace. Non è chiaro se si tratti di un bug temporaneo o di una scelta strategica permanente. Tuttavia, le ipotesi sul tavolo sono diverse e tutte plausibili.

La motivazione più ovvia è proprio quella di ostacolare lo scraping massivo.

Questi strumenti, per quanto utili a noi professionisti, mettono a dura prova le risorse dei server di Google e, in un certo senso, “sfruttano” il suo indice per alimentare servizi concorrenti di analisi. Togliere loro lo strumento più efficiente per raccogliere dati su larga scala è una mossa difensiva logica.

Un’altra ragione potrebbe essere l’allineamento all’esperienza utente reale.

La stragrande maggioranza delle persone non va oltre la prima pagina di risultati. Mostrare 10, e non 100, risultati per pagina è il comportamento standard. Allineare le modalità di raccolta dati a come si comportano gli utenti reali rende le metriche più pulite e rappresentative della realtà, meno inquinate da casi limite e automazioni.

Non va sottovalutata poi la questione dei costi e delle prestazioni.

Servire 100 risultati per ogni richiesta è tecnicamente più oneroso che servirne 10.

Oggi efficienza energetica e velocità contano più che mai: ridurre il numero di risultati permette di rendere le ricerche più rapide e di consumare meno risorse, con un impatto enorme se si considera la quantità di richieste generate ogni giorno nel mondo.

Oppure potrebbe essere una semplice misura di sicurezza per prevenire abusi e traffico generato da bot con scopi malevoli.

C’è chi, infine, vede un secondo fine più malizioso: mettere a tacere le critiche sul “Great Decoupling” e l’impatto negativo dell’IA sui click, sgonfiando la bolla delle impression per dimostrare che, dopotutto, l’effetto non era così drammatico.

Una mossa tattica, da politici navigati, più che una semplice modifica tecnica…

Cosa devi fare ora? Non farti prendere dal panico, ma preparati al futuro

La prima regola, in questi casi, è: niente panico. I dati che vedi in questo momento su Google Search Console sono probabilmente distorti. Non prendere decisioni strategiche basate su questo crollo di impression o su questo aumento di posizione media.

Non licenziare la tua agenzia SEO né raddoppiarle il budget. Aspetta.

La situazione è ancora in evoluzione e Google potrebbe fornire chiarimenti o addirittura ripristinare la funzionalità.

Quello che questo episodio ci insegna, però, è una lezione fondamentale per il tuo business.

Primo: i dati non sono mai la verità assoluta, ma una rappresentazione della realtà, e gli strumenti di misurazione possono cambiare.

Secondo, e più importante: la visibilità organica non può più essere legata solo alla classifica su una lista di link blu.

Il mondo della ricerca è cambiato come ben sai.

Le persone non “cercano” più, “chiedono”.

Chiedono a Google, chiedono a ChatGPT, chiedono agli assistenti vocali.

Vogliono risposte, non link.

Il tuo obiettivo, come imprenditore, non è più solo “essere primo su Google”. È fare in modo che il tuo brand, i tuoi prodotti, la tua expertise diventino la risposta, come è emerso chiaramente anche dalla nostra chiacchierata con Jono Alderson.

La risposta che l’intelligenza artificiale sceglie di dare, la fonte che cita, il risultato che presenta in modo prominente.

Questo significa lavorare sulla costruzione di un’autorità reale, creare contenuti di valore eccezionale, strutturare i dati del tuo sito in modo che le macchine possano comprenderli senza ambiguità e costruire un brand di cui le persone – e di conseguenza gli algoritmi – si fidano, come ci ha detto Andrea Volpini nel corso della nostra intervista.

L’incidente del &num=100 è un campanello d’allarme. Ci sta dicendo che le vecchie metriche e i vecchi metodi stanno diventando obsoleti.

Il futuro non è monitorare la posizione 99, ma assicurarsi di essere la fonte della risposta in posizione zero. È un cambio di paradigma che richiede un consulente SEO capace di interpretare non solo gli algoritmi di oggi, ma anche le architetture conversazionali di domani.

La tua visibilità, e le tue vendite, dipendono da questo. Non farti trovare impreparato.

Google chiude &num=100 e manda in tilt la Search Console: Domande Frequenti

Perché il numero di impression nella Google Search Console è crollato?

Il calo delle impression è legato alla rimozione del parametro &num=100 nelle URL di ricerca di Google. Questo parametro permetteva ai bot di scraping di visualizzare 100 risultati in una sola pagina, generando impression fantasma. Con la sua eliminazione, questi dati non vengono più registrati, rendendo le metriche più realistiche.

Perché la posizione media di molti siti è migliorata improvvisamente?

La posizione media è migliorata perché sono state eliminate le impression false registrate nelle posizioni molto basse (80, 90 o 100). Senza questi dati sporchi, il calcolo della media si concentra solo sulle posizioni realmente viste dagli utenti, dando l’illusione di un miglioramento SEO.

Quali sono le possibili ragioni della decisione di Google?

Google potrebbe aver rimosso il parametro &num=100 per ridurre lo scraping massivo, allineare i dati al comportamento reale degli utenti che visualizzano solo 10 risultati per pagina, migliorare l’efficienza dei server e contenere i costi energetici. Alcuni analisti ipotizzano anche una mossa tattica per ridimensionare il dibattito sul “Great Decoupling”.

Cambiare le metriche non cambia la sostanza. E se Google punta tutto sull’IA, dove finiamo noi?

Interessante questa “pulizia” dei dati. Mi domando quanto questo influenzerà le nostre attuali metriche.

Ah, quindi ora i bot erano troppo “rumorosi”? Sembra che Google voglia solo che ci concentriamo sulle posizioni “migliori”, ma la vera battaglia per le risposte IA è appena iniziata.

Solito teatrino di Google. Ripulire i dati è un eufemismo per nascondere la polvere sotto il tappeto. Ormai contano solo le risposte dell’IA, il resto è fuffa.

Mah, ‘sto cambio di Google sembra più un trucco per farci credere che le cose vanno meglio. Alla fine, cambiano il modo di contare, non le performance. Ora tutti a rincorrere l’IA, ma chi ci dice che non la cambieranno pure quella?

La rimozione del parametro ha ripulito i dati, ma la vera sfida è ora nell’IA.

Comprendo la confusione generale, ma questa mossa di Google, seppur spiazzante, potrebbe aiutarci a focalizzarci sulla qualità reale delle nostre ricerche. Ci spinge a costruire contenuti che rispondano davvero alle esigenze degli utenti, piuttosto che a ingannare algoritmi.

Ricalibrare le metriche è necessario per una lettura più fedele. La vera sfida è ora adattarsi ai nuovi modi di cercare risposte.

Capisco la perplessità generale di fronte a questo cambiamento. Sembra che i vecchi modi di misurare il successo non siano più validi. La vera sfida ora non è più la “posizione” ma diventare una fonte affidabile per l’AI. Mi chiedo se siamo pronti per questa nuova era di ricerca.

Sempre le solite trovate per fare pulizia nei dati. E ora?

Un cambio di rotta che purifica i dati, ma ci spinge a guardare oltre le solite metriche.

Capisco, sembra che stiamo tutti un po’ smarriti con questi cambiamenti. Forse è un buon momento per concentrarci su contenuti che rispondano veramente alle persone.

Capisco la confusione con i dati, ma forse è una spinta a concentrarsi sulla qualità reale. Se i bot non contano più, dobbiamo puntare a essere utili agli utenti. La vera sfida è farsi notare dall’AI, giusto?