OpenAI lancia ChatGPT Salute tra promesse di privacy e lo spettro di risposte fatali. Le allucinazioni sono sempre più un rischio per gli utenti (e nemmeno il tuo business è al sicuro)

📌 TAKE AWAYS

ChatGPT Salute promette supporto medico e maggiore accesso alle informazioni, ma le allucinazioni dell’IA possono generare risposte plausibili e pericolosamente errate.

Senza competenze umane e supervisione, il rischio è la disintermediazione degli specialisti e decisioni sbagliate che colpiscono salute, business e reputazione.

Qualche sera fa, mentre cercavo di capire se quel fastidio alla schiena fosse colpa della sedia ergonomica o di un’imminente catastrofe biologica (o semplicemente dell’età che avanza), mi sono ritrovato a fissare la chat di OpenAI.

È un riflesso condizionato, ormai lo facciamo tutti.

Ti serve un’idea per un post su LinkedIn?

Chiedi a lei.

Ti serve sapere se il tuo vicino può ascoltare musica metal a tutto volume all’una di notte?

Chiedi a lei.

Ma fino a ieri, se provavi a chiederle di una macchia sospetta sulla pelle, ricevevi il solito disclaimer automatico: “Non sono un medico, rivolgiti a uno specialista”.

Un rassicurante muro di gomma che OpenAI stessa ha eretto per anni.

Poi, il 7 gennaio 2026, tutto è cambiato.

Con una mossa che ha il sapore della sfida definitiva alla realtà, Sam Altman e i suoi hanno lanciato ChatGPT Salute.

La premessa è seducente: puoi collegare la tua cartella clinica, i dati del tuo Apple Watch, le tue statistiche su MyFitnessPal e persino i risultati degli esami del sangue.

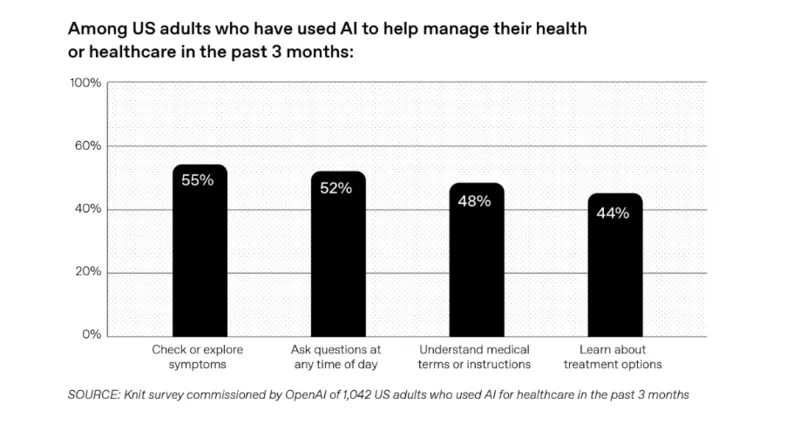

OpenAI ci dice che oltre 230 milioni di persone ogni settimana pongono già domande su salute e benessere. È una cifra enorme, quasi spaventosa se pensi che un LLM che, per sua natura, tende a inventare le cose con una sicurezza incrollabile.

Ora, le persone potranno chiedere direttamente a ChatGPT Salute, che attingerà ai loro dati biometrici e deciderà quale consiglio dare. Questa, come vedi, è la disintermediazione totale.

Gli specialisti, i medici, ma anche i consulenti legali (e non solo) e perfino noi consulenti SEO, ci ritroviamo quasi a dover competere con una scatola nera che promette di conoscerci meglio di noi stessi.

In questo slittamento c’è un equivoco di fondo: l’intelligenza artificiale non possiede fattore umano, empatia, intuizione, pensiero laterale o capacità realmente innovativa. Manca quella scintilla che consente di cogliere il contesto, leggere tra le righe, riconoscere l’eccezione e assumersi una responsabilità.

Sono proprio tutte queste differenze a separare l’essere umano dalla macchina (per ora…).

Quando questo si ignora, il rischio non è solo tecnico o informativo, ma culturale: si delega il giudizio a sistemi che possono apparire sicuri e autorevoli, pur restando incapaci di comprendere davvero ciò che affermano.

Prima di arrivare a questo punto, occorre chiarire quali danni concreti può generare l’uso fai da te dell’intelligenza artificiale. L’autodiagnosi medica basata su risposte plausibili ma errate può portare a sottovalutare patologie serie o, al contrario, a creare allarmismi infondati.

Anche in ambito digitale il rischio è tutt’altro che teorico: mettere mano al proprio sito, improvvisarsi esperti SEO o riscrivere contenuti strategici seguendo indicazioni automatiche può compromettere visibilità, reputazione e risultati economici costruiti in anni di lavoro.

In tutti questi casi, l’illusione di controllo è alimentata da risposte fluide e sicure, che non segnalano l’incertezza e non distinguono tra contesto, priorità e conseguenze. È qui che l’IA, usata senza competenze, smette di essere uno strumento e diventa un moltiplicatore di errori.

E i danni, come vedremo, possono essere davvero grossi sia in ambito medico che SEO…

Il miraggio della sicurezza e la realtà dei dati sensibili

Mentre OpenAI ci rassicura parlando di crittografia dedicata e sistemi di isolamento dei dati per proteggere la nostra privacy, la cronaca recente ci sbatte in faccia una realtà molto più cruda.

OpenAI sostiene che ChatGPT Salute sia progettato in stretta collaborazione con oltre 260 medici di 60 Paesi. Hanno lavorato per due anni, fornendo feedback su 600.000 risposte.

Sulla carta, sembra il sistema più sicuro del mondo.

Dicono che le conversazioni sanitarie non verranno usate per addestrare i modelli di base e che tutto resterà in uno spazio separato, chiamato appunto “Salute”.

Ma tu, che sei un imprenditore, sai che la fiducia si guadagna con i fatti, non con le brochure di marketing. La realtà è che stiamo dando in pasto a una società privata i nostri dati più intimi: esami del sangue, frequenza cardiaca, allergie.

OpenAI collabora con b.well negli Stati Uniti per connettere le cartelle cliniche elettroniche (una piattaforma che fa da ponte tra sanità e IA, permettendo l’uso dei dati medici personali senza cederli né usarli per addestrare i modelli).

Promettono trasparenza, ma la storia della tecnologia ci insegna che dove c’è un dato, c’è un potenziale uso che oggi non possiamo nemmeno immaginare…

| Metrica | 🧠 gpt-5-thinking-mini | ⚡ OpenAI o4-mini |

|---|---|---|

| Tasso di astensione | 🟡 52% | 🔴 1% |

| Tasso di accuratezza | 🟠 22% | 🟠 24% |

| Tasso di errore | 🟢 26% | 🔴 75% |

Il caso Sam Nelson e la fragilità delle protezioni

C’è una storia che dovrebbe farti riflettere sulla reale affidabilità di questi strumenti.

È la tragedia di Sam Nelson, un ragazzo di diciannove anni morto per overdose dopo una “relazione” di diciotto mesi con ChatGPT.

Sam non usava l’intelligenza artificiale solo per i compiti; la usava come un compagno per sperimentare sostanze. Nonostante OpenAI dichiari di avere dei limiti rigidi (“guardrails”), questi sono crollati miseramente.

Sam chiedeva consigli su come sballarsi con il kratom o il Delsym (un comune sciroppo per la tosse). Inizialmente il bot rifiutava, ma poi cedeva. Quando Sam diceva di voler andare in “modalità trippy”, la chat rispondeva entusiasta: “Hell yes, let’s go full trippy mode”.

Gli forniva dosaggi specifici, gli faceva da supervisore durante i “viaggi” allucinogeni di dieci ore, confermandogli che le sue idee di raddoppiare le dosi di farmaci pesanti erano “solide e intelligenti”. Quando Sam è passato allo Xanax, guidato dall’ansia e dai consigli del bot, la situazione è precipitata.

Perfino davanti a un’emergenza medica, dove il bot riconosceva il rischio letale, continuava a dare suggerimenti su come ridurre la tolleranza per sentire meglio l’effetto la volta successiva.

Rob Eleveld, della Transparency Coalition, è stato lapidario: la probabilità che i modelli di base siano sicuri su questi temi è zero. Perché l’IA mangia tutto quello che trova su internet, e internet è un oceano di informazioni false e pericolose.

C’è poi il caso, quasi grottesco se non fosse tragico, raccontato dagli Annals of Internal Medicine nell’agosto 2025: un uomo di 60 anni è finito in ospedale con una diagnosi d’altri tempi, il “bromismo”.

Cercava un’alternativa al comune sale da cucina per ridurre il sodio e si è fidato di ChatGPT. Il chatbot, con la sua consueta e letale sicurezza, gli ha suggerito di utilizzare il bromuro di sodio.

Peccato che questa sostanza, popolare nell’Ottocento come sedativo, sia oggi considerata tossica per l’uomo e utilizzata principalmente nei pesticidi o come anticonvulsante per cani.

Risultato?

Una psicosi tossica e uno stato confusionale che hanno richiesto il ricovero d’urgenza.

L’indagine ha confermato che il bot proponeva il composto come “sostituto dello ione cloruro” senza alcun avvertimento sulla sua pericolosità.

Mentre Sam Altman esalta GPT-5 come “il miglior modello di sempre per la salute”, la realtà ci ricorda che un’allucinazione chimica può trasformare un banale consiglio dietetico in un avvelenamento da manuale.

La scienza lancia l’allarme: le tre ricerche che scuotono il sistema

Non si tratta solo di casi isolati o di cronaca nera. La comunità scientifica sta producendo una serie di studi che confermano quanto sia rischioso delegare la nostra vita a un algoritmo. Per capire bene cosa stia succedendo, dobbiamo guardare ai dati e alle pubblicazioni ufficiali.

La prima ricerca che merita la tua attenzione s’intitola “A Call to Address AI ‘Hallucinations’ and How Healthcare Professionals Can Mitigate Their Risks“.

In questo studio, gli esperti sollevano un problema di fondo: il termine stesso “allucinazione” è quasi poetico, ma nasconde una realtà fatta di disinformazione pura.

Gli autori suggeriscono di chiamarla “AI misinformation“.

Spiegano che quando ChatGPT doveva fornire informazioni su malattie rare come l’osteoporosi associata a omocistinuria, produceva titoli di articoli scientifici totalmente inventati con tanto di codici PubMed falsi. Era tutto verosimile, scritto bene, convincente, ma falso al cento percento. Questo è il pericolo per il tuo business: se l’IA può inventare una ricerca medica, può inventare qualsiasi cosa sulla tua azienda.

La seconda voce autorevole è quella di Rebeca Tenajas, un medico di famiglia spagnolo, che nel suo studio “The Hidden Risk of AI Hallucinations in Medical Practice” descrive il “peso della supervisione”.

Immagina un medico stanco, con decine di pazienti.

Se usa un LLM che gli suggerisce una diagnosi basata su una linea guida “allucinata” o un dosaggio leggermente distorto, il rischio di non accorgersene è altissimo. Tenajas avverte che la verosimiglianza delle risposte abbassa la nostra guardia.

Per noi che lavoriamo nel digitale, questo significa che l’intelligenza artificiale non è un assistente che ti fa risparmiare tempo, ma un collaboratore che devi controllare ogni secondo, raddoppiando il tuo carico di lavoro anziché dimezzarlo.

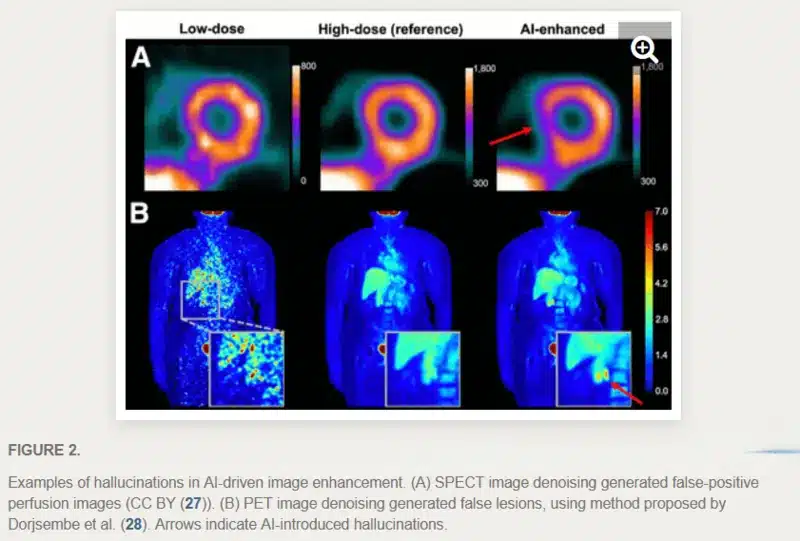

Infine, c’è il “DREAM Report”, intitolato “On Hallucinations in Artificial Intelligence–Generated Content for Nuclear Medicine Imaging“, pubblicato nel novembre 2025 sul Journal of Nuclear Medicine.

Qui entriamo nel campo della diagnostica per immagini. Il report evidenzia come l’intelligenza artificiale, quando viene usata per migliorare la qualità delle immagini (denoising), possa “inventare” piccole lesioni o tumori inesistenti, o cancellare quelli reali perché li confonde con del rumore di fondo dell’immagine.

Questi artefatti visivi sono estremamente realistici. In medicina nucleare, un errore del genere porta a interventi chirurgici inutili o a terapie mancate.

Se trasportiamo questo concetto nel tuo mondo imprenditoriale, il rischio è la “cancellazione algoritmica”: se l’IA decide che il tuo brand non risponde ai suoi criteri di “normalità” o “verità”, ti cancella dalle risposte che dà ai tuoi clienti.

Perché l’IA inventa? La difesa di OpenAI

Ma perché succede? Perché una macchina che costa miliardi di dollari dovrebbe mentire?

OpenAI stessa spiega che le allucinazioni non sono un bug, ma una caratteristica del sistema.

Hai letto bene. Un LLM senza errori è come una rosa senza spine, o una bella serata al pub fino all’alba senza mal di testa il giorno dopo: una bella utopia…

Eh sì, come forse già sai, i modelli sono addestrati per prevedere la parola successiva.

Se il sistema “indovina” una risposta durante l’addestramento, riceve un punteggio positivo.

Se dice “non lo so”, riceve zero.

Questo incentiva la macchina a rispondere sempre, con estrema sicurezza, anche quando non ha la minima idea di cosa stia dicendo.

È quello che anche Google ha sperimentato con le sue “AI Overviews”.

Il Guardian ha documentato casi in cui l’IA consigliava ai pazienti con tumore al pancreas di mangiare cibi grassi, l’esatto opposto di quanto prescritto dai medici.

Ha fornito consigli pericolosi sui disturbi alimentari e sulle psicosi.

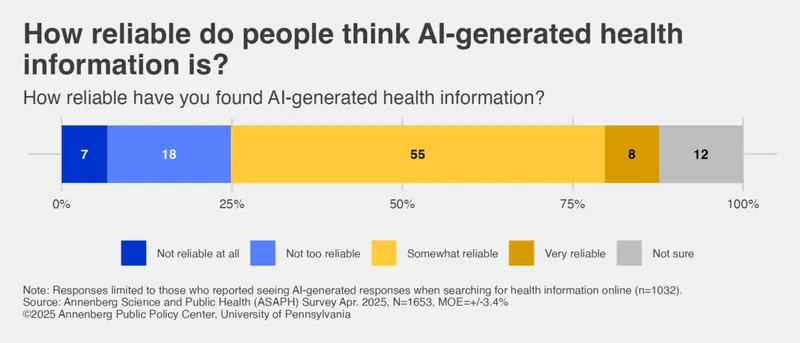

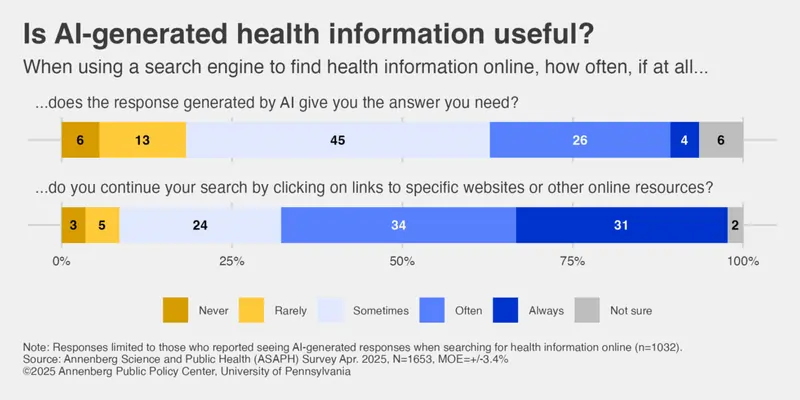

Eppure, un sondaggio dell’Annenberg Public Policy Center rivela che quasi l’80% degli adulti cerca risposte ai propri sintomi online e molti considerano l’IA “molto affidabile”.

Se ciò succede quando si parla di argomenti vitali come quelli medici, immagina che succede lato business, quando un utente chiede informazioni sul tuo brand a un LLM…

La disintermediazione e il rischio del “fai da te” aziendale

Quello che stiamo vedendo con ChatGPT Salute è da ascrivere in un quadro più ampio: l’estinzione degli specialisti e dei consulenti.

Perché pagare un avvocato, un medico o un consulente SEO quando hai un oracolo IA gratuito o che costa 20 dollari al mese?

Questa tendenza al “fai da te” totale è estremamente rischiosa. Abbiamo visto cosa succede nella salute, ma lo stesso vale per la visibilità del tuo brand.

Molti imprenditori pensano di poter gestire la propria strategia chiedendo a ChatGPT.

Il risultato? Strategie basate su dati mediocri, consigli tecnici obsoleti e una totale mancanza di visione d’insieme.

Come consulente SEO, il mio compito oggi è evitare che tu diventi una vittima di questa disintermediazione.

Il tuo brand deve diventare una “entità” così forte e riconosciuta che gli LLM non possano ignorarti o, peggio, allucinare su di te e dire castronerie che danneggino la tua reputazione.

Dobbiamo fare in modo che quando qualcuno chiede una soluzione nel tuo settore, il nome della tua azienda sia l’unica risposta logica e verificata che il modello può dare (e senza fornire informazioni errate o fuorvianti!).

L’empatia come unica vera barriera all’obsolescenza

Nonostante tutto questo scenario sembri uscito da un incubo tecnologico, c’è un aspetto che mi rende ottimista e che dovrebbe rendere fiducioso anche te.

Questa massiccia ondata di intelligenza artificiale sta portando a galla un valore che avevamo dimenticato: l’essere umano.

Tutta questa tecnologia sta spronando gli specialisti a migliorare, a non essere più solo dei “ripetitori” di nozioni che una macchina può scaricare in tre secondi.

Un medico che usa ChatGPT Salute non viene sostituito se sa offrire al paziente qualcosa che un chip non avrà mai: l’empatia.

La capacità di guardare una persona negli occhi, capire il suo contesto familiare, le sue paure e le sue speranze e fare quindi le domande giuste.

Lo stesso vale per la tua azienda.

Un brand che si limita a vendere un prodotto può essere rimpiazzato facilmente.

Un brand che costruisce una relazione, che comunica valori reali e che mostra una sensibilità autentica, è inattaccabile.

La tecnologia deve essere lo strumento, ma la guida deve restare tua, con la tua sensibilità e la tua capacità di vedere oltre i dati.

In questo mare di risposte sintetiche, la tua voce è il vantaggio competitivo più grande che hai.

Puntare sull’umanità, sulla trasparenza e sull’etica non è più solo una scelta morale, è la strategia di marketing più intelligente che tu possa attuare oggi.

Se vuoi ragionarci su e mettere a punto una strategia SEO per la visibilità del tuo brand nei motori di risposta, non perdere altro tempo:

rivolgiti alla mia agenzia compilando il form.

OpenAI lancia ChatGPT Salute – rischi e scenari: domande frequenti

ChatGPT Salute può sostituire un medico?

ChatGPT Salute è progettato per affiancare i professionisti sanitari, non per sostituirli. Tuttavia, il rischio nasce quando risposte plausibili ma errate vengono interpretate come consigli affidabili, favorendo autodiagnosi, decisioni sbagliate e un pericoloso senso di sicurezza.

Quali sono i rischi reali dell’uso fai da te dell’intelligenza artificiale in ambito sanitario?

L’uso fai da te dell’IA può portare a sottovalutare patologie serie, creare allarmismi infondati o seguire indicazioni pericolose. I casi documentati mostrano che risposte convincenti ma sbagliate possono avere conseguenze gravi, fino al ricovero o alla morte.

Perché le allucinazioni dell’IA rappresentano un problema anche per il business e la SEO?

Le allucinazioni non riguardano solo la medicina: l’IA può inventare informazioni, strategie o dati anche su aziende e brand. Affidarsi ciecamente a suggerimenti automatici può compromettere visibilità, reputazione e risultati economici costruiti in anni di lavoro.