Le intelligenze artificiali ascolteranno tutte le nostre conversazioni? Forse sì

Spesso ci preoccupiamo di quello che pensano di noi le altre persone. E, forse, presto ci dovremo preoccupare di quello che pensano di noi le macchine.

L’evoluzione dell’intelligenza artificiale ci sta avvicinando sempre di più al giorno in cui i software non si limiteranno a eseguire istruzioni, ma analizzeranno e interpreteranno le nostre parole, le nostre emozioni, le nostre intenzioni. E mentre questa realtà può sembrare un incredibile passo avanti per la tecnologia, può rappresentare un enorme passo indietro per la nostra privacy e libertà personale.

Uno scenario da romanzo orwelliano?

Forse no, visto l’ambito affrontato da una recente ricerca sull’intelligenza artificiale.

Le AI potrebbero analizzare tutto ciò che scriviamo nelle nostre conversazioni

Ok, seguimi bene.

Di recente è stata pubblicata una ricerca che studia come le intelligenze artificiali possano essere utilizzate per scansionare messaggi e conversazioni alla ricerca di indizi che rilevano la violazione di norme sociali.

Te lo spiego in parole più semplici: in sostanza, i ricercatori, appartenenti all’Università Ben Gurion del Negev (Israele), hanno cercato di capire se le AI sono in grado di comprendere se abbiamo fatto qualcosa di ‘sbagliato’ a partire dall’analisi delle nostre parole. E non si tratta di rilevare comportamenti necessariamente illeciti, ma qualsiasi azione possa aver infranto una norma sociale.

E che significa?

Seguimi che te lo spiego.

Le norme sociali: un campo troppo soggettivo per darlo in pasto alle AI

Vedi, con ‘norme sociali’ si possono intendere molte cose. È un termine che indica un insieme di regole e comportamenti condivisi all’interno di una società, che fungono da guida per il comportamento dei suoi membri e che stabiliscono ciò che è considerato appropriato o inappropriato in diverse situazioni.

Ecco alcuni esempi:

- le leggi e i regolamenti, norme sociali esplicite, ovvero formalmente definite, scritte e condivise tra noi tutti;

- il modo di salutarsi, ad esempio l’idoneità o meno di farlo con una stretta di mano, con un abbraccio, con un bacio e via dicendo;

- la scelta di abiti appropriati a determinate situazioni sociali, come eventi formali o cerimonie religiose;

- la necessità di mantenere un comportamento educato e in linea con il contesto in cui ci si trova;

- e mille altre.

Insomma, salvo le normative legislative, tutto il resto appartiene alla sfera soggettiva. Non sono oggettivamente fisse, ma cambiano in base a chi siamo, al luogo da cui veniamo, al mondo in cui siamo stati abituati a crescere.

Ma, secondo le parole dei ricercatori, “mentre le norme sociali possono essere culturalmente specifiche e coprire numerose “regole” informali, il modo in cui le persone rispondono alla violazione delle norme attraverso le emozioni, basate sull’evoluzione, può essere molto più generale e fornirci spunti per l’identificazione automatica della violazione delle norme… I risultati supportano l’importante ruolo delle emozioni sociali nel segnalare la violazione delle norme e puntano alla loro futura analisi e al loro utilizzo per comprendere e rilevare la violazione delle norme“.

Pertanto, l’AI, in particolare GPT-3, è stato messo alla prova nel rilevare la presenza di emozioni di vergogna o sensi di colpa nei nostri messaggi come prova di una violazione delle norme sociali.

Chi c’è dietro tutto questo?

Fin qui, a mio parere, stiamo già abbondantemente sconfinando nel campo della distopia. Studiare l’addestramento delle intelligenze artificiali allo scopo di analizzare e rilevare la violazione delle norme sociali tramite l’identificazione di segnali nascosti dietro le nostre parole solleva enormi interrogativi etici e legati alla privacy.

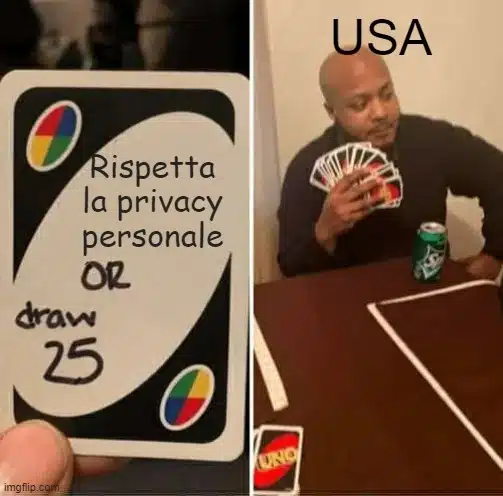

Ma qui il nodo della questione riguarda specialmente l’identità di chi potrebbe ritrovarsi in mano queste informazioni. E, se vai a spulciare il link alla ricerca che hai trovato all’inizio dell’articolo, in particolare la sezione che raccoglie le informazioni relative a chi ha sovvenzionato lo studio, leggerai che a farlo è stata niente di meno che la DARPA, cioè la nota agenzia governativa statunitense dedicata allo sviluppo di tecnologie militari.

Ora, lungi da me gridare al complotto, perché non sappiamo i motivi principali che hanno spinto il Pentagono a promuovere questa iniziativa. Ma finché non abbiamo risposte più precise in merito, una delle ipotesi più plausibili è un possibile utilizzo delle AI a fini di sorveglianza.

Ma sorveglianza nei confronti di chi?

Beh, per il momento sembrerebbe che non sia nei confronti dei cittadini statunitensi, bensì verso le popolazioni straniere. Sì, perché lo studio è stato finanziato in particolare all’interno del programma Computational Cultural Understanding, un’iniziativa della DARPA che, come si legge sul sito dell’agenzia, “mira a creare tecnologie di comprensione linguistica interculturale per migliorare la consapevolezza situazionale e l’efficacia interattiva degli operatori del DoD [n.d.r. DoD sta per Department of Defense, ovvero il Dipartimento della Difesa americano]”.

Il Grande Fratello sarà una macchina?

Questa notizia solleva diverse considerazioni preoccupanti riguardo all’uso dell’intelligenza artificiale e alla sua applicazione nel contesto della sorveglianza e della valutazione della ‘colpevolezza’ di un essere umano a partire da considerazioni partorite da quello che, di fatto, è un semplice software, per quanto evoluto:

- privacy e sorveglianza.

L’idea che l’AI venga utilizzata per analizzare i testi delle persone per rilevare violazioni delle norme sociali potrebbe costituire un serio pericolo per la libertà di espressione e per il diritto di ognuno di noi a mantenere la privacy delle proprie conversazioni; - ambiguità delle norme sociali.

Queste regole variano notevolmente da cultura a cultura e anche all’interno di una stessa società. Determinare una definizione univoca di ‘violazione’ è impossibile e porta inesorabilmente a interpretazioni errate, specialmente se le AI sono preda di pregiudizi legati a una programmazione imperfetta; - problemi etici relativi all’analisi delle emozioni umane da parte di un AI.

E qui non credo ci sia bisogno di aggiungere molto altro. Perché di tutto abbiamo bisogno fuorché di una specie di strizzacervelli virtuale che scava tra le nostre parole alla ricerca di ammissioni di colpe indimostrabili; - controllo delle tecnologie da parte dei governi.

Come accennato, la ricerca è stata finanziata dal Pentagono, portando alla luce il ruolo delle autorità americane nella promozione di queste tecnologie. Ciò solleva domande riguardo alla trasparenza e al controllo democratico sull’uso di tecnologie di sorveglianza e di intelligenza artificiale a fini militari e governativi, specialmente se l’iniziativa venisse importata al di là dell’oceano, ad esempio qui in Europa; - possibili ripercussioni sociali.

L’analisi della violazione delle norme sociali tramite l’AI potrebbe essere utilizzata per scovare comportamenti legali, ma censurabili sotto il punto di vista morale, dando a chi possiede queste informazioni una potente leva per colpire la reputazione dell’interessato e influenzare il suo operato.

| Problema legato all’utilizzo dell’AI per la sorveglianza delle conversazioni | Descrizione del problema | Potenziali implicazioni |

|---|---|---|

| Privacy e sorveglianza | L’uso dell’AI per analizzare i testi delle persone può costituire una minaccia per la libertà di espressione e la privacy delle conversazioni personali. | Potrebbe limitare la libertà di espressione, violare la privacy, e impattare negativamente la democrazia. |

| Ambiguità delle norme sociali | Le norme sociali variano da cultura a cultura. Determinare una definizione univoca di ‘violazione’ è complicato e può portare a interpretazioni errate. | Potenziali errori di interpretazione, discriminazione, e incomprensioni culturali. |

| Problemi etici dell’analisi delle emozioni | L’analisi delle emozioni umane da parte di un’AI solleva preoccupazioni etiche. | Potrebbe portare a manipolazione emotiva, violazione della privacy emotiva e abuso di dati sensibili. |

| Controllo delle tecnologie da parte dei governi | Il ruolo delle autorità nel promuovere queste tecnologie solleva domande sulla trasparenza e il controllo democratico. | Potenziali abusi di potere, sorveglianza di massa, e minacce alla democrazia. |

| Possibili ripercussioni sociali | L’uso dell’AI per analizzare le violazioni delle norme sociali potrebbe essere usato per danneggiare la reputazione delle persone. | Potenziali danni alla reputazione, manipolazione dell’opinione pubblica e pressioni sociali indebite. |

Insomma, se si trattasse di ricerca fine a sé stessa questa cosa non mi preoccuperebbe più della recente modifica della privacy di Google.

Ma, visto il contesto in cui si sta sviluppando, non posso che pensare ai vari Orwell, Bradbury, Dick e compagnia cantante che si sono impegnati per raccontarci scenari distopici. E l’hanno fatto per metterci in guardia da tutto questo, non per prenderlo come esempio.

Ma questo, evidentemente, non l’abbiamo ancora capito. E il primo psicopoliziotto della storia dell’uomo potrebbe essere diverso da come ce lo siamo immaginato. Non un umano, ma una fredda macchina.

Il primo psicopoliziotto della storia dell’uomo potrebbe essere diverso da come ce lo siamo immaginato. Non un umano, ma una fredda macchina.

Quello che possiamo imparare da questa notizia per il nostro business digitale

Lavoro come consulente SEO da una vita e, per deformazione professionale, non ho potuto fare a meno di ragionare su questa notizia in termini di marketing digitale. E penso che possiamo trarre degli importanti insegnamenti da questa storia ancora tutta da scoprire in ogni sua sfacettatura.

Partiamo dal fatto che, ciò che mi disturba (e che, probabilmente, disturba anche te) è la possibilità che un AI inizi a psicoanalizzarmi, a decidere cosa c’è di giusto e di sbagliato dietro le mie parole, a cercare presunti indizi di colpevolezza in ogni mia conversazione. Perché, se la ricerca si concretizza nello sviluppo di una tecnologia che verrà effettivamente utilizzata, significa delegare la responsabilità di interpretare le emozioni umane e giudicare i comportamenti a un algoritmo.

E la delega di responsabilità e di compiti che dovrebbero essere nostri nelle mani delle AI è un pericoloso trend che sto osservando anche nel web marketing.

L’automazione e l’intelligenza artificiale hanno sicuramente rivoluzionato il settore digitale, offrendo strumenti potenti per l’analisi dei dati, la creazione dei contenuti e l’ottimizzazione dei processi interni. Ma in tutto questo si dimentica che la grande forza che muove il marketing sono i consumatori, esseri umani come noi con emozioni complesse che non sono riducibili a stringhe di codice.

Pertanto, per coinvolgerli in modo significativo le aziende devono mostrare autenticità e comprensione delle loro esigenze, coniugandole con una buona dose di creatività perché le campagne di successo si basano su idee innovative e capacità di pensiero fuori dagli schemi, qualità intrinsecamente umane.

Delegando tutto alle AI rischiamo di assistere a un appiattimento delle strategie e a un impoverimento delle esperienze del consumatore. E questo sarebbe la morte per le aziende che cadono nella trappola.

Dunque, la sfida oggi è trovare il giusto equilibrio tra l’utilizzo dell’intelligenza artificiale come supporto e il mantenimento dell’approccio umano e creativo nell’ideazione e nell’esecuzione delle strategie.

In conclusione

L’uso di intelligenza artificiale per analizzare e interpretare i nostri discorsi, secondo il recente studio, apre un panorama preoccupante di fronte al rischio di una grave intrusione nella privacy individuale e di un uso distorto di queste tecnologie, soprattutto se usate a fini di sorveglianza o controllo sociale.

Ritornando al nostro mondo del marketing digitale, vediamo paralleli inquietanti. Il progresso tecnologico è certamente un alleato prezioso, ma non dobbiamo dimenticare che il cuore del marketing è fatto di relazioni umane. Le intelligenze artificiali possono aiutarci a comprendere e rispondere in modo più efficace alle esigenze del consumatore, ma non possono sostituire la creatività, l’empatia e la razionalità umana.

La sfida quindi, sarà trovare un equilibrio tra l’uso responsabile dell’IA e la tutela della dignità, della privacy e della libertà individuale. In tale scenario, gli operatori del settore digitale hanno il dovere di guidare la trasformazione in modo consapevole e sostenibile, mettendo sempre al centro la persona.

L’AI potrebbe essere il nostro più grande alleato o il nostro peggior nemico. Sta a noi decidere cosa sarà davvero.

Il mio consiglio?

Utilizzare l’AI come un utile strumento per migliorare e ottimizzare le nostre attività, ma senza mai dimenticare che dietro ogni click, ogni like, ogni acquisto, c’è un essere umano con le sue emozioni, le sue esperienze, i suoi valori. Perché in un mondo sempre più digitalizzato, l’unico vero vantaggio competitivo sarà sempre di più l’umanità.

🏆 Take Aways…

- L’evoluzione dell’intelligenza artificiale sta aprendo la possibilità di analizzare e interpretare le nostre conversazioni, parole ed emozioni.

- La ricerca sull’AI per rilevare violazioni di norme sociali tramite analisi delle emozioni solleva preoccupazioni etiche riguardo alla privacy e alla libertà di espressione.

- Le norme sociali sono soggettive e variabili tra culture e individui, rendendo difficile una definizione univoca di “violazione”.

- L’utilizzo delle AI a fini di sorveglianza solleva interrogativi sulla trasparenza e il controllo democratico delle tecnologie.

- Nel marketing digitale, l’uso dell’IA può essere prezioso, ma è fondamentale mantenere l’approccio umano e creativo per comprendere le esigenze dei consumatori.