Domanda di cui conosco la risposta: Ci tieni davvero all’ottimizzazione SEO del tuo sito?

Magari hai studiato il SEO copywriting e ora vuoi scovare i segreti dell’esperto SEO?

Allora non puoi davvero ignorare il concetto di Crawl Budget!

Qui ti mostrerò perché si tratta di un fattore decisivo per posizionare le pagine più importanti del sito ed in egual misura per raggiungere i tuoi obiettivi strategici sul web.

Imparando a governare il Crawl Budget, potrai aumentare le visite al sito e concederti la reale possibilità di dialogare alla pari con il motore di ricerca e i suoi bot.

Grazie ad alcuni accorgimenti tecnici puoi infatti indicare agli algoritmi i contenuti che contano davvero e che meritano priorità in fase di scansione.

Dal punto di vista tecnico, questa è una di quelle best practices SEO dalle quali non si può fare a meno, specialmente su siti di grosse dimensioni.

Andiamo a fondo nel concetto di “Budget di Crawling”

Prima di approfondire il concetto di Crawl Budget per chi è alle prime armi è molto importante familiarizzare con il concetto di Googlebot.

Googlebot è il nome conferito al bot che va a ficcare il naso in qualsiasi sito web presente in rete alla ricerca di nuove pagine da aggiungere all’indice affinché vengano trovate dagli utenti.

Dal momento che su internet esistono miliardi di pagine e nuove ne vengono create in ogni momento, sarebbe impossibile per il bot di Google visitarle tutte ogni singolo giorno.

Ecco, quindi, da dove nasce il concetto di “Crawl Budget”:

Se il crawling è l’attività di scansione del bot su un sito, il Crawl Budget è la stima che determina quanto spesso il bot di Google tornerà nel tuo sito al fine di verificare l’esistenza di pagine o nuove informazioni da indicizzare.

Il concetto di Crawl Budget può essere a sua volta spaccato in due, ovvero in:

- Crawl Rate Limit

- Crawl Demand

Crawl Rate Limit (Limite di Scansione)

Il bot di Google è stato concepito per essere un buon cittadino del web.

In pratica entra nel sito a farsi i fatti tuoi, ma cerca di farlo in punta di piedi senza sovraccaricare il server con il rischio d’influenzare l’esperienza utente.

Questo è il “rate limit”, ovvero il limite riferito alle connessioni simultanee che Googlebot può usare per fare la scansione del sito.

Questo limite può aumentare o diminuire in base a due fattori:

- Capacità di Crawling.

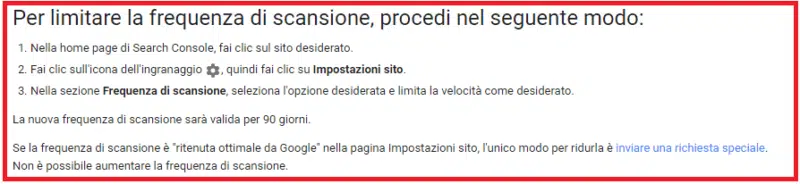

Se un sito risponde davvero velocemente alle visite da parte del bot, allora automaticamente il “Crawl Limit” sarà spostato verso l’alto. Se invece il sito rallenta o si verificano errori lato server, il limite si abbassa e il bot farà meno scansioni. - Impostazioni da Search Console.

I webmaster possono anche decidere di settare manualmente il suddetto limite, abbassandolo o alzandolo, ma è da notare che settando limiti più elevati non si otterrà automaticamente più attenzione da parte del bot.

In pratica, Google vuole evitare di sovraccaricare il tuo sito mandando il bot a scansionarlo troppo pesantemente. Il Crawl Limit non serve altro che a prevenire che il bot faccia troppe richieste al sito con il risultato di rallentarlo.

Crawl Demand (Esigenza di Scansione)

Anche nei casi in cui il limite di crawling non viene raggiunto, se non ci sono richieste di indicizzazione, l’attività del bot sarà minima.

A riguardo ci sono due fattori che determinano il grado di attenzione del bot:

- Popolarità.

Gli URL che riscuotono maggiore popolarità su internet tendono a ricevere più scansioni per mantenerli sempre aggiornati. - “Crawl Demand”.

Letteralmente indica l’esigenza di scansione, ovvero quanto il bot percepisca come obsoleto il contenuto di certe URL.

In occasione di eventi speciali che riguardano l’intero sito come le migrazioni, il cambio di template, il Crawl Demand cresce in quanto c’è necessità di indicizzare un sito sotto nuove URL.

Mettendo insieme il concetto di Crawl Demand e Crawl Limit si definisce al meglio anche quello di “Crawl Budget” che in sostanza può essere visto come il numero di URL che Googlebot può e vuole scansionare.

Crawl Budget: come aiuta la SEO?

Ora che ti ho riempito la testa con tutte queste informazioni starai pensando:

“Scusa Robbè, ma io che me ne faccio di tutte ste menate!? Come mi cambia la SEO del sito?”

Come hai compreso il Crawl Budget non è un fattore di ranking diretto, ma in verità può comunque incidere molto sulla visibilità del tuo sito in SERP.

Ci sono almeno 3 ragioni per cui dovresti preoccuparti del tuo Crawl Budget:

- Se Google manda molto spesso il suo bot nel tuo sito significa che lo tiene in buona considerazione. Inoltre, significa che il bot è sempre ben accolto e che non ci sono problemi di scansione. L’algoritmo, quindi, percepisce che si tratta di un sito costantemente aggiornato e vale la pena ripassare spesso.

- Specialmente per siti di più grandi dimensioni, che pubblicano spesso contenuto o che aggiornano continuamente quello vecchio, sarebbe importante che il bot passi il più in fretta possibile così da mostrare agli utenti il nuovo contenuto fresco in tempi brevi.

- Non va poi dimenticato che le pagine scansionate di recente hanno migliori possibilità di posizionarsi bene nei risultati di ricerca, mentre le pagine che non ricevono scansione da tempo tendono a perdere posizionamento.

Un importante “ragione bonus” consiste poi in un importante concetto: se la struttura del tuo sito consuma crawl budget su varianti di pagine e contenuti non fondamentali è molto probabile che quest’ultimo limiti la capacità di Google di scansionare le pagine che invece a te interesserebbe e vorresti posizionare sui motori di ricerca.

Ottimizzare il Crawl Budget per la SEO: aspetti pratici

Se sei arrivato fin qua sotto a leggere ti faccio i miei complimenti, anche perché il bello viene ora.

Eccomi allora a parlarti di come si ottimizza il Crawl Budget per la SEO del tuo sito attraverso alcuni accorgimenti pratici.

Partiamo però da un presupposto: il Crawl Budget va visto come un indicatore della qualità del lavoro che fai sul tuo sito web.

Quindi, in realtà, quello che devi fare non è intervenire direttamente su di esso, piuttosto devi ottimizzare alcuni aspetti del sito per poi vedere come risponde il Crawl Budget.

Come monitorare il Crawl Budget

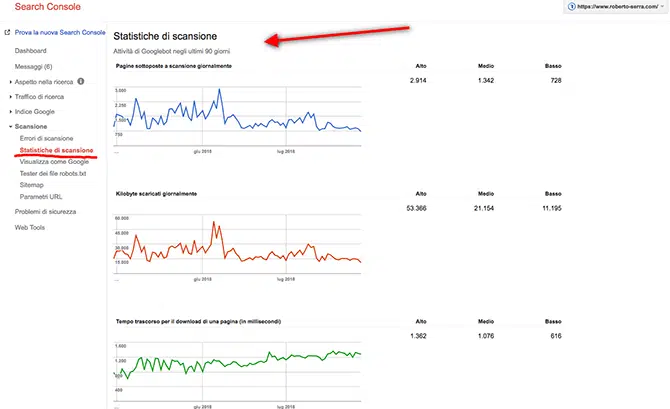

Una volta che avrai implementato le migliorie che stai per conoscere, puoi monitorare l’attività del bot sul sito grazie alla search console, qui sono presenti le statistiche di scansione che ti diranno:

- Kb scaricati ogni giorno

- Pagine analizzate

- Tempo impiegato per l’operazione

Se hai un numero di scansioni superiore a quello delle pagine significa che Google dialoga benissimo con il sito e ti tiene in grande considerazione.

Migliorare il Crawling in 5 passi

Quali aspetti del tuo sito, se ottimizzati, ti porteranno ad avere un eccellente budget di crawling? In questi 5 passi ti spiegherò come intervenire on-site e off-site per far innamorare Googlebot.

- Nota Bene: ricordati solo di non esagerare e non spingerti oltre il flirt. Probabilmente hai un partner (moglie/marito o fidanzata/o) e non vorrei venisse a bussarmi alla porta armato di cattive intenzioni visto che sono io che ti ho fatto conoscere queste tecniche :D.

#1 Questione di Qualità e Frequenza

Un sito fresco è un sito che piace a Google. Aggiornalo! La frequenza di pubblicazione è un fattore da non trascurare, ma non buttarti sulla quantità. Pubblica il giusto, ma che siano sempre contenuti di qualità.

Pubblicare aiuta a richiamare l’attenzione del bot, ma allo stesso modo aggiornare contenuti vecchi ti aiuta a rimanere sempre attraente.

#2 Snellisci e Ottimizza il Sito

Al bot non piace perdere tempo in percorsi inutili e fuorvianti, anzi molto spesso nei casi peggiori è costretto a passare attraverso percorsi addirittura dannosi.

Per questo sono assolutamente da evitare i casi di pagine del tipo:

- Contenuti duplicati

- Errori 404

- Pagine Hackerate

- Spam

- Informazioni di servizio

Devi essere tu a indicare la strada migliore al bot, puoi farlo anche attraverso il file robots.txt dove puoi stabilire quelle pagine che Googlebot dovrà ignorare mettendole in noindex.

#3 Parametri URL

Pochi lo sanno, ma sulla search console esiste anche uno strumento utile a indicare al bot come gestire i parametri URL.

Se pensiamo a un e-commerce, per esempio, molto spesso il problema è quello di gestire le varianti di pagina tramite parametri. Su uno shop online l’utente può scegliere vari criteri per ordinare i prodotti:

- Prezzo (crescente, decrescente)

- Data (recente, meno recente)

- Alfabetico (a – z / z – a)

In questo caso se non si vanno a gestire i parametri URL a dovere, si possono causare problemi di contenuto duplicato e inoltre si spende male il Crawl Budget perché Google scansiona più pagine del necessario ripassando più e più volte tra le stesse.

#4 Il ruolo dell’hosting

Crawl Budget e hosting sono molto correlati.

Se fai in tempo a prenderti un caffè prima che le pagine del tuo sito vengano caricate a causa del server, allora potresti avere seri problemi con il Crawl Budget.

Se il bot ha la possibilità di leggere le pagine in maniera pratica e veloce lavorerà meglio e il webmaster avrà delle ottime risorse di crawl budget. Un buon hosting deve comprendere SSD, http/2 e ovviamente un buon up-time. A questo proposito, se cerchi un hosting performante ti consiglio di provare questo

Leggi anche: Miglior Hosting WordPress 2021 (SEO Oriented)

#5 Fattore Off-Site: i link in entrata

Se vuoi che Google e il suo algoritmo ti tengano nella giusta considerazione è importante inoltre non scordarsi dei link in entrata.

Grazie ai link in ingresso il tuo sito potrà acquisire trust e questo porta anche a un aumento indiretto del Crawl Budget.

Il consiglio per acquisire link in entrata resta sempre lo stesso: lavorare sulla qualità dei contenuti del sito affinché gli utenti e altri webmaster abbiano tante buone ragioni per linkare i tuoi contenuti o in alternativa fare link building al meglio!

Leggi anche: 5 opportunità che ignori del mio servizio di Link building (Non per tutti)

Conclusioni sul Crawl Budget

E tu che Crawl Budget hai? In questa guida hai avuto modo di scoprire l’importanza di questo fattore piuttosto tecnico, ma fondamentale, per instaurare un rapporto prolifico con Google.

Il mio consiglio è di iniziare subito a lavorare sul tuo crawl budget: solo così puoi assicurarti che il motore di ricerca non trascuri il tuo sito!

Aspetta però, se non sei sicuro di dove mettere le mani per cominciare, affidati a un professionista che sappia implementare una strategia a 360° e ottimizzare al massimo il Crawl Budget per mettere le ali al tuo sito 🙂